概要

Ollama を利用する際に GUI や WebUI ベースでのインタフェースがあると利便性が上がります。Open WebUI は、ローカルまたはリモートの LLM を管理・利用するためのウェブベースのインターフェースです。

Open WebUI を導入するには、Docker や Kubernetes の環境を用意する方法もありますが、Windows 上で行うには WSL2 に依存する部分があるので、個人的にはオーバヘッドが少し大きいのかなという印象です。

(Docker や Kubernetes を使うメリットはもちろんあると思います)

Docker や Kubernetes を利用せずに、Python / uv を用いたインストール方法だと、コマンド2つのみで Open WebUI の実行環境を簡単に用意できましたので情報残しておきます。

Open WebUI とは

Open WebUI は、もともとは Ollama WebUI として開発されていましたが、Ollama だけでなく オープン性と柔軟性への取り組み、幅広い LLM のサポートなどの観点から Open WebUI となったようです。(参考)

公式サイト

https://openwebui.com/

https://docs.openwebui.com/

Open WebUI is an extensible, feature-rich, and user-friendly self-hosted AI platform designed to operate entirely offline. It supports various LLM runners like Ollama and OpenAI-compatible APIs, with built-in inference engine for RAG, making it a powerful AI deployment solution.

https://docs.openwebui.com/

(機械翻訳)

Open WebUI は、完全にオフラインで動作するように設計された、拡張可能で機能が豊富でユーザーフレンドリーなセルフホスト型 AI プラットフォームです。Ollama や OpenAI 互換 API などのさまざまな LLM ランナーをサポートし、RAG 用の推論エンジンが組み込まれているため、強力な AI 展開ソリューションとなっています。

Open WebUI のインストール方法

公式のドキュメントにインストール方法は記載されています。

https://docs.openwebui.com/getting-started/quick-start/

Choose your preferred installation method below:

https://docs.openwebui.com/getting-started/quick-start/

- Docker: Officially supported and recommended for most users

- Python: Suitable for low-resource environments or those wanting a manual setup

- Kubernetes: Ideal for enterprise deployments that require scaling and orchestration

公式にサポートしているのは Docker を用いる方法ですが、ここでは Python で行ってみます。

Python を利用する場合、さらに uv, Conda, venv の方法が用意されていますが、ここでは uv を使ってみようと思います。

Python / uv で Open WebUI をインストールする (Windows上)

公式サイトのに記載されている手順に準拠します。

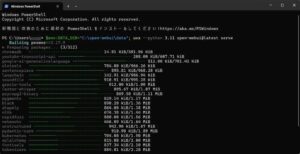

(1) uv のインストール

PowerShell で以下を実行します。

Windows 11 で行う場合は、[ターミナル] を起動して実行すればよいです。

コマンドプロンプトではなく、[ターミナル] か [PowerShell] での実行が必要なので、その点だけ注意してください。

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

これは比較的すぐ完了します。

表示にある通り、env を設定するか、ターミナルを起動しなおします。(ここではターミナルを起動しなおしました。)

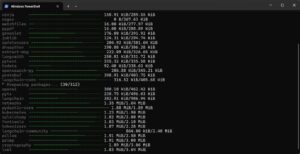

(2) Open WebUI のインストールと起動

起動しなおしたターミナルで、以下を実行します。

この $env:DATA_DIR=”C:\open-webui\data” で指定するフォルダは、Open WebUI のデータを置くフォルダです。

あらかじめ作成しておく必要はありません。環境に合わせて変更してください。

$env:DATA_DIR="C:\open-webui\data"; uvx --python 3.11 open-webui@latest serve

必要なファイルのダウンロードなどが行われて、Open WebUI が起動します。(ブラウザは自動起動しません。)

わかりづらいですが、以下が表示されたら ブラウザを開き http://localhost:8080 にアクセスしてみます。

INFO: Started server process [xxxx]

INFO: Waiting for application startup.

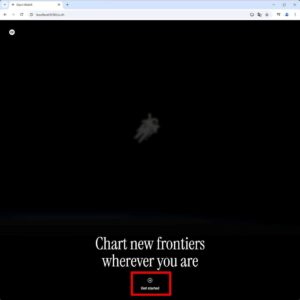

Open WebUI が起動していると以下の画面が表示されます。下のほうの Get started の上の → をクリックします。

管理者ユーザの情報を登録します。

新機能のダイアログが表示されます。

[OK、始めましょう] をクリックします。

Open WebUI が表示されます。

左上のドロップダウンのところから、ollama で pull 済みのモデルが選択できます。

モデル選択後、プロンプトの入力を行います。

ターミナルを閉じると Open WebUI は終了します。

2回目以降の Open WebUI の起動

再度開始したい場合は、ターミナルで先ほどと同じコマンドを実行すればよいです。

$env:DATA_DIR="C:\open-webui\data"; uvx --python 3.11 open-webui@latest serve

削除したい場合

削除したい場合は、以下のフォルダ、およびファイルを削除さればよいでしょう。

- C:\Users\ユーザ名\.webui_secret_key

- C:\Users\ユーザ名\AppData\Local\uv\

- C:\Users\ユーザ名\.local

- Open WebUI データフォルダ (上の例だと C:\open-webui\)

ユーザの環境変数 Path にも C:\Users\ユーザ名\local\bin が追加されているので不要であれば削除します。

まとめ

2つコマンドを実行するだけで Open WebUI を導入できました、思ったよりも簡単です。

別ページで記載しましたが Ollama も Windows 版のインストールは非常に簡単でした。

導入後、モデルの追加や削除は Ollama のコマンドベースで行う必要がありますが、手軽に LLM を WebUI で試す環境は用意できるといえます。

参考となれば幸いです。

▼ 関連ページ